(来源:刘润)

中美AI竞争的终局,可能不是拼“算力”,而是拼“电力”。因为AI越猛,越吃电。谁能把这笔电费扛住,谁就能撑到最后。

最近的一些消息,让我越来越相信这个观点。比如前段时间,英国《金融时报》的一则报道。报道说,中国启动了针对AI的电费补贴。在某些数据中心密集的省份,只要你在数据中心全面使用国产芯片,就可以减免你的电费,最高50%。

有人说,这么多啊,这可省钱了。也有人说,短期是省钱了,可是,能一直这样下去吗?到时候补贴一停,估计又要回到解放前了。

怎么说呢?在我看来,这个补贴,与其说是短期的产业扶持,不如说是我们在AI竞争中,发起了一次“非对称”回击,用廉价充裕的电力优势,弥补芯片性能劣势。

一个电费补贴,怎么就成“回击”了?它到底打到哪了?

要回答这个问题,我们得先去看看我们的对手,正在经历的一场能源危机。

01 美国AI产业的瓶颈,已经从芯片转向了电力

你知道吗?最近美国的科技巨头们,找电都快找疯了。

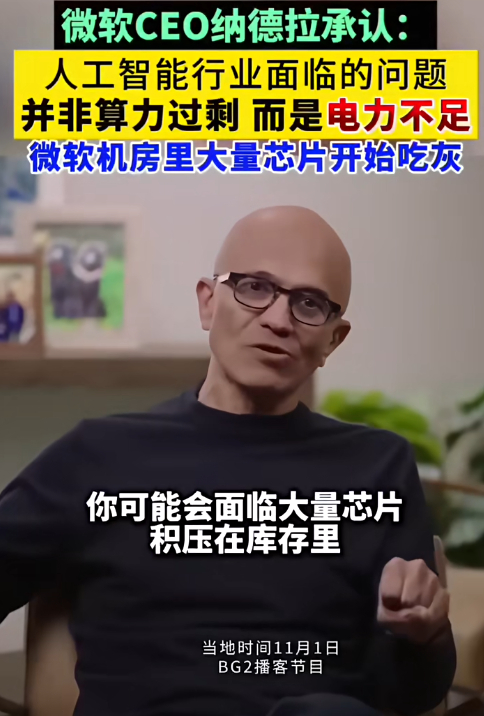

这话不是我说的。是微软的CEO纳德拉说的:现在的最大问题不是计算(芯片)过剩,而是电。如果电力跟不上,即便仓库里堆满芯片也没用。品品这话。世界顶尖的科技巨头,手握最先进的算力芯片,最大的烦恼,居然是找不到足够的插座。

(图片来自视频号:半导体俱乐部)

为什么会这样?因为搞人工智能,真是太耗电了。

当ChatGPT每日响应约2亿个请求时,耗电就足以支持1.7万个美国家庭的用电。这还只是一个AI应用的电量。预计到2035年,美国AI算力产生的电力需求,还会翻一番以上。

但是,美国的电网,又特别不给力。他们的电网系统,大部分建造于几十年前,甚至更早。北美电网运营商就曾发出警告:未来几年,辖区内很有可能间歇式停电。摩根士丹利也说,2030年左右,美国某些区域的电力缺口,可能高达20%,AI就是其中很重要的原因。

当需求爆炸,但供给却动不了、修不快时,麻烦就来了。

弗吉尼亚州北部的劳登,一度是全球最大的数据中心市场之一。2025年,政府宣布加紧数据中心项目的审批。原因之一,就是电网的输电能力已经跟不上需求。同样的情况发生在亚利桑那州的图森。他们拒绝了亚马逊的大型新数据中心项目,因为项目消耗了太多电和水。

那怎么办呢?AI巨头们,只好砸钱。

为了给云计算和人工智能项目供电,微软签署购电协议,重启三哩岛核电站1号机组,并买下未来20年该电站的所有电力。亚马逊觉得电网效率太低,于是,干脆花了6.5亿美金,在电站旁边买下了数据中心园区,直接接入了发电厂。

电力,客观上已经成为了美国AI产业的瓶颈之一。

02 我们正在用能源优势,弥补产品性能劣势

聊完美国,再回来看中国。你会发现,我们正在用自己的能源优势,补产品劣势。

什么能源优势?

早在2022年,AI大爆发之前,我们就已经启动了一项超级工程:东数西算。

在中国,有一个天然的“错位”。风电、光电资源最丰富的地方,比如内蒙古、贵州,电力用不完。而最需要电的企业,比如有大量数据要处理的互联网企业,却都挤在东部的北上广深,这里寸土寸金,电价也贵。

怎么办?

那就,把东边的数据,搬到西部计算。让中国西部那些可能被闲置的,清洁廉价的电力,被东部需要算力的企业更大规模地用起来。这就是,东数西算。

这个伏笔,很多年前就种下了。于是,在AI这个用电大户横空出世的今天,它让我们拥有了充足的能源优势。

但这还不够。因为,真正的挑战在于:我们要推动国产芯片替代。因为在AI竞赛里,大模型是标,芯片是本。治标,不如治本。

而阻碍一家企业从英伟达换成国产芯片,除了产品性能的差距之外,还有两个难关。

第一个难关,是电费成本。

有评估认为,产生同样多的算力,我们的芯片要多花30%到50%的电。也就是说,本来100万的电费,换了之后,要多花30-50万。

第二个难关,是生态迁移成本。

CUDA,是一套让程序员更好用英伟达GPU的编程工具。如果说,英伟达的GPU是AI时代的“电脑主机”,那么,CUDA就是AI时代的“Windows系统”。换芯片,就意味着软件工程师,要花大约6到18个月的时间,把过去十几年,在CUDA上积累的所有代码、模型、工具链,推倒重来,适配新生态。比如,华为的CANN。

这两个难关,怎么跨过去?答案之一,就是:电费补贴。补贴的真正威力,在于它从根本上,改变了一家企业看待国产芯片的“成本视角”。

当一家公司在评估一项新技术时,它的成本公式是这样的:

总成本 = 采购成本 + 运营成本(电费占大头) + 迁移成本

在这个公式下,国产芯片很难占优,企业自然没有动力去选择。但现在,这个公式里,就出现了两个,我们独有的减项。

第一个减项,叫“能源调度红利”。

东数西算,让你的基础电费,从一开始就比别人低了一大截。

第二个减项,叫“财政补贴”。

这就是这次的电费补贴。它在你已经很低的电费基础上,再砍一刀。

于是,一个全新的、只属于中国的“AI算力成本公式”,诞生了:

总成本 = [采购成本 + 运营成本 + 迁移成本] – 能源红利 – 财政补贴

我们没有在公式的前半部分,去跟对手硬拼。而是用我们独有的“系统能力”,改变了最终的计算结果。这就是:用能源优势,补产品劣势。

电力补贴,本质是用运营成本优惠,去覆盖生态迁移成本,从而为国产芯片产业,争取到建设生态和迭代技术,最宝贵的时间。

03 弹药、扳机、目标:一个完整的反制系统

拆到这里,事情就清楚了。三件看似独立的事,背后,其实是一个闭环。

东数西算,是弹药。

它解决的,是能源供给和单位算力成本的问题,让我们在“谁有电、谁便宜”这条赛道上占据先手。

电费补贴,是扳机。

它规定了这批弹药该怎么用,只有换上国产芯片,你才能用上这笔便宜电。

国产芯片,和以CANN为代表的国产生态建设,则是我们要精准打击的,那个目标。

弹药决定能打多久,扳机决定能不能打,目标决定打向哪。这三者一起,构成了一个从资源到成本、再到生态的闭环。而这个闭环的目的,从一开始就不止是防守,而是,进攻。进攻的方向,至少有两个。

第一,英伟达的生态霸权。

英伟达的CUDA生态,就像AI领域的Windows操作系统。它用极其高昂的迁移成本,锁住了所有用户。我们现在要做的,是用自己巨大的内需市场,催熟CANN的国产替代。一旦它在市场里,被验证、完善,英伟达一家独大的局面,就有被撕开口子的可能。

第二,AI的成本基础。

因为能源危机,未来搞AI,成本会越来越高。而我们这里,因为东数西算和电费补贴,成本相对可控。当未来的AI竞赛,从百米冲刺变成一场消耗战的时候,谁的成本更低,训练更好的模型,谁或许就能,笑到最后。

当正面战场胜算不大的时候,唯一的出路,或许是重新定义战场。

最后的话

英伟达用CUDA生态,统治了AI的上半场。那是一个拼芯片性能、拼算法优化的时代。在那个游戏里,我们确实起步晚了。

但现在,游戏规则正在悄悄改变。

当AI从实验室走向大规模商业应用,当模型越来越大、训练越来越频繁,这场竞争就不再只是技术的竞争,而是资源的竞争。不再只是拼谁的芯片更快,而是拼谁能承受得起这场持久战的成本。

丰富的清洁能源,完善的电网基础设施。这些,都是我们在上一个时代积累的“隐藏资产”。现在,它们开始发挥作用了。

所以,才有这么一句话:美国最怕的,不是华为的芯片,而是中国的电网。

当然,这不意味着我们可以躺平。芯片性能的差距,仍然需要时间来弥补。软件生态的建设,更是一场需要耐心的马拉松。但至少,我们找到了一条可能的路径:用能源换时间,用时间换技术,用技术换生态。

技术拼到最后,往往成了拼资源。而我们,最不怕的就是这个。

参考资料:

- FINANCIAL TIMES:China offers tech giants cheap power to boost domestic AI chips

- 三哩岛核电站将重启为微软AI供电,曾发生美国史上最严重核事故

- 美国宾州史上最大投资!亚马逊200亿押注核电数据中心

- Tucson City Council rejects Project Blue data center amid intense community pressure

- The Resource Adequacy Report

观点/ 刘润 主笔/ 景九 编辑 / 歌平 版面 / 黄静

https://finance.sina.com.cn/roll/2025-11-15/doc-infxmzee2198863.shtml